I den digitale tidsalderen blir kunstig intelligens (AI) stadig mer utbredt, og finner applikasjoner i en rekke bransjer. Nylig har vi sett fremdriften i Googles prosjekt for å generere musikk fra en enkel "forespørsel". I dag oppdager vi det også Meta hun startet seg inn i dette eventyret, skaper språkmodeller i stand til generere lyd fra en tekstbeskrivelse. Navnet på dette revolusjonerende verktøyet er 'AudioCraft'.

Meta Audiocraft: en ny horisont for generering av musikk tilgjengelig for alle (eller nesten alle)

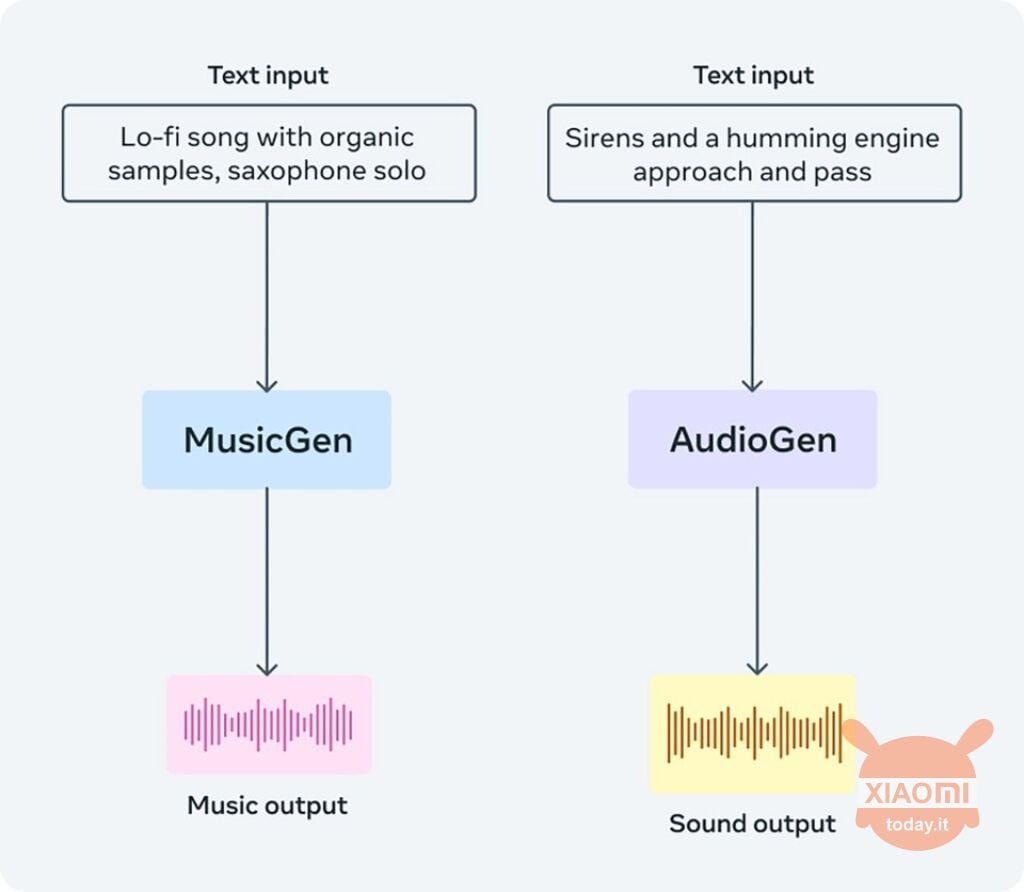

Audiocraft er et AI-basert verktøy som drar nytte av tre språkmodeller: AudioGen, EnCodec og MusicGen. Målet er å la brukere få tak i lydspor med utgangspunkt i en enkel tekstbeskrivelse av hva de ønsker å lytte til. Audiocraft kan brukes til å generere både musikk og lyder, i tillegg til å tilby komprimeringsfunksjonalitet.

Blant de tre modellene, MusicGen er den spesifikt opplært til å generere musikk fra tekst. For å gjøre dette ble tusenvis av musikkspor lisensiert av Meta brukt. Den mest spennende nyheten er at alle tre modellene har blitt lansert i åpen kilde, som betyr at alle kan bruke dem til å bygge verktøy og applikasjoner. I følge Meta ble disse malene designet spesielt for musikalske artister og lyddesignere, med målet om å "gi inspirasjon."

Les også: Metas nye strategi for målrettet annonsering: brukertillatelse

Malene er allerede tilgjengelige og koden deres kan lastes ned gjennom Klemme ansiktet eller den aktuelle siden Github. MusicGen kan brukes til å få AI-genererte utdrag av musikksanger, mens AudioGen kan gi brukbare lyder for musikkproduksjon. EnCodec, derimot, er et AI-basert komprimeringsverktøy.

Å generere et musikkstykke, det er det beskriv musikken du vil ha og trykk på 'Generer'-knappen. Videre kan du følge beskrivelsen med en lydfil eller et opptak av mikrofonen din for å la modellen behandle den typen musikk du ønsker å generere mer presist.

Den genererte lyden vil være et spor på omtrent 12 sekunder. For å få et verktøy som kan generere mer komplette tekstutdrag, må vi vente på at en utvikler lager en app basert på disse modellene. Meta gitt verktøyene, nå er det opp til fellesskapet å finne ut hva som kan gjøres med dem.